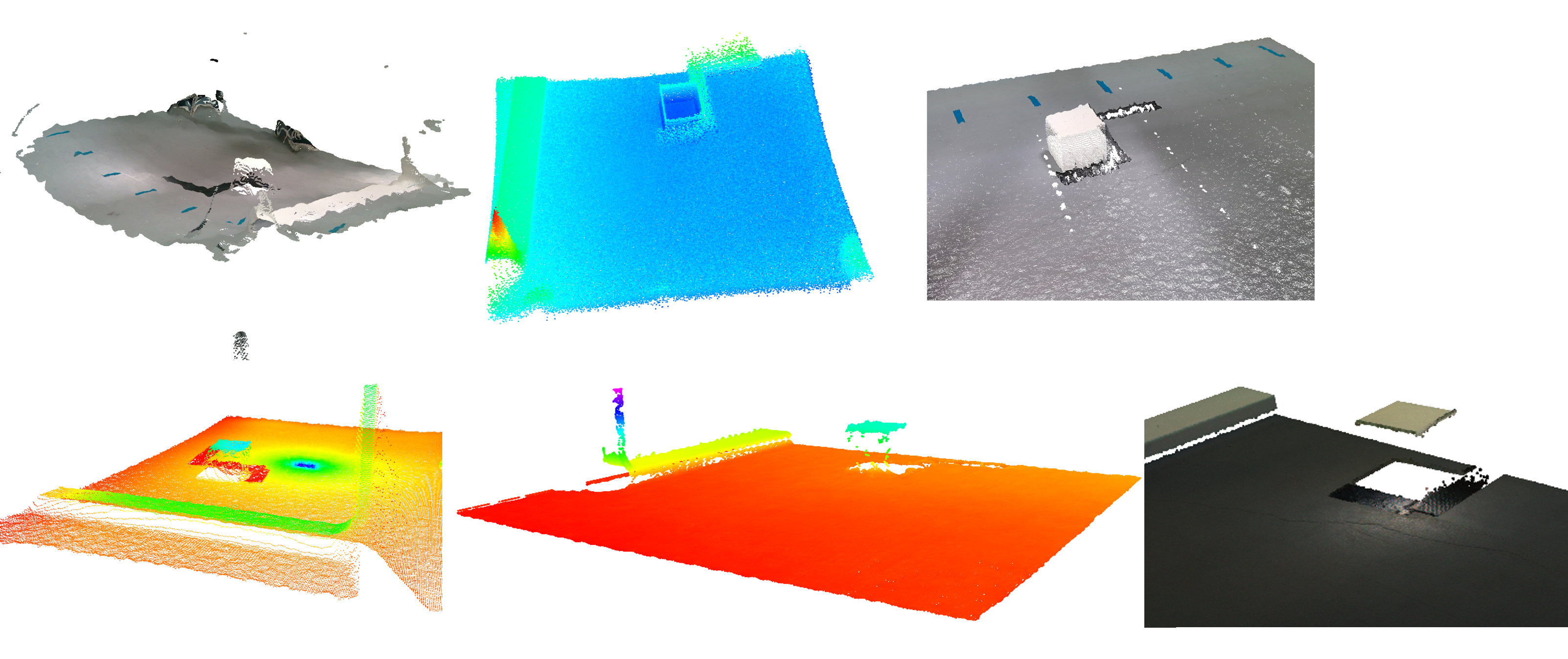

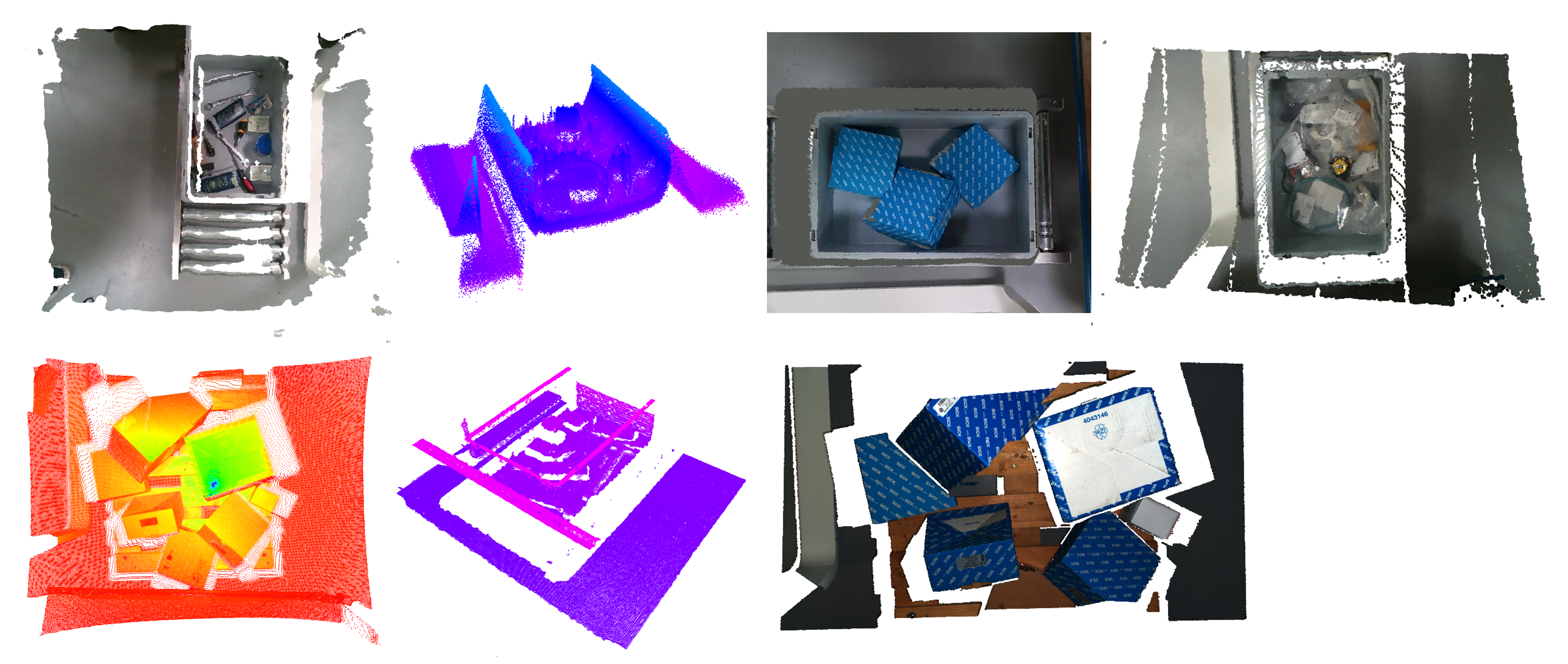

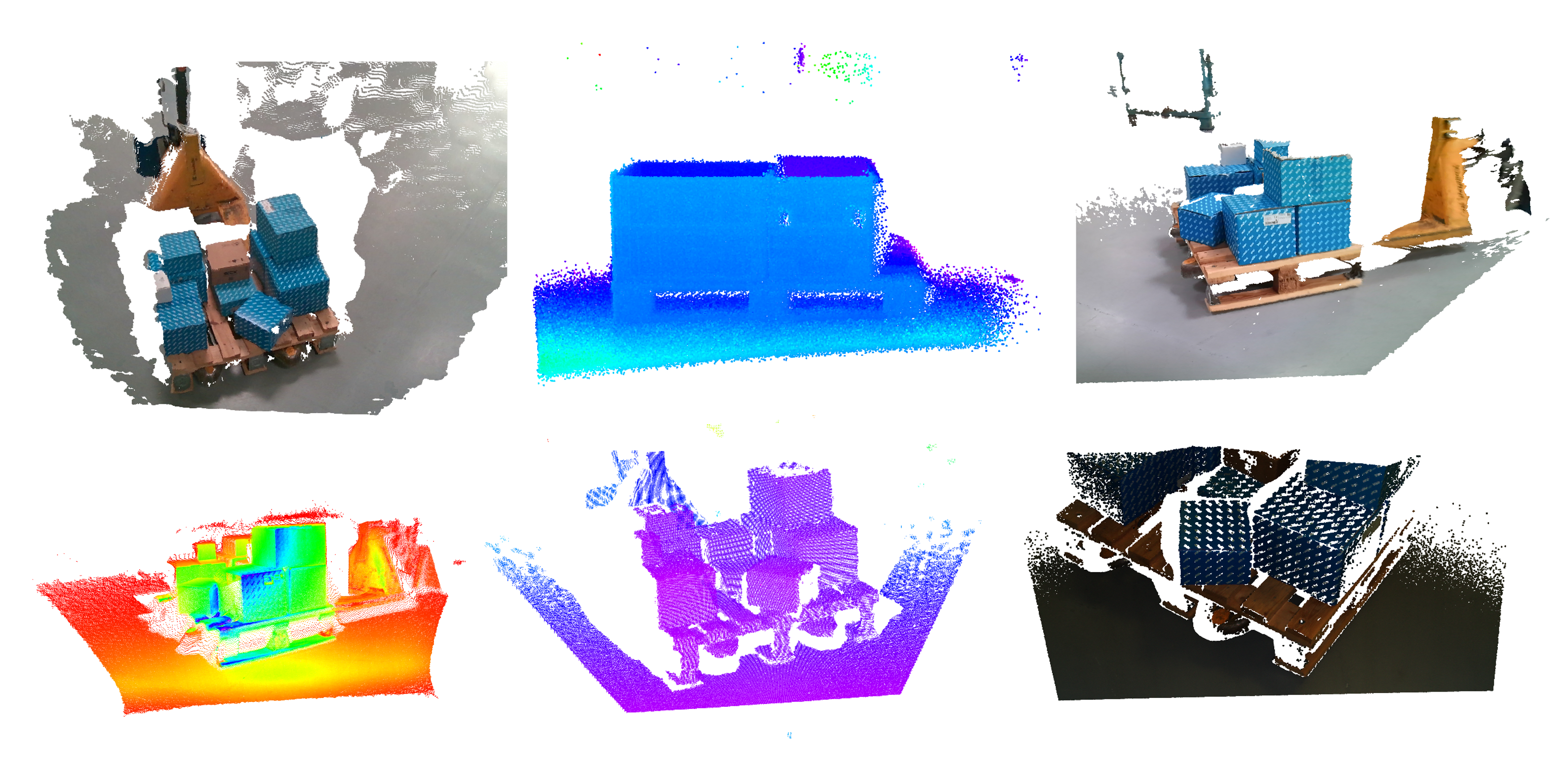

3D-Sensoren erfassen Tiefendaten von Objekten und Umgebungen, wodurch sie sich ideal für die Objekterkennung, -detektion und -lokalisierung im dreidimensionalen Raum eignen. Da verschiedene 3D-Sensoren unterschiedliche Eigenschaften wie Preis, verwendete Technologie, maximale Reichweite und Qualität der erzeugten Daten aufweisen, wurde am Fraunhofer IML ein kalibrierter und synchronisierter Datensatz für logistische Szenarien, sowie zu Evaluationszwecken aufgenommen. Eine Liste der verwendeten Sensoren befindet sich in der untenstehenden Tabelle.

Sensoren aus dem Paper

| Intel RealSense D455 |

| P+F SmartRunner Explorer 3-D |

| Azure Kinect DK |

| Intel RealSense L515 |

| Sick T-mini |

| Sick Visionary-S |

| Zivid Two |

Fraunhofer-Institut für Materialfluss und Logistik IML

Fraunhofer-Institut für Materialfluss und Logistik IML